1. Introducción: Cuando despertar era un milagro

¿Se ha preguntado alguna vez cómo sería someterse a una cirugía completamente consciente, sintiendo cada corte del bisturí, cada punto de sutura, cada manipulación de órganos y tejidos? Esta era la realidad cotidiana de la medicina hasta hace menos de dos siglos. La anestesia —ese milagro químico que nos permite «apagar» temporalmente la consciencia y el dolor— representa uno de los avances más revolucionarios en la historia de la humanidad, comparable quizás con el descubrimiento del fuego o la invención de la rueda en su impacto transformador.

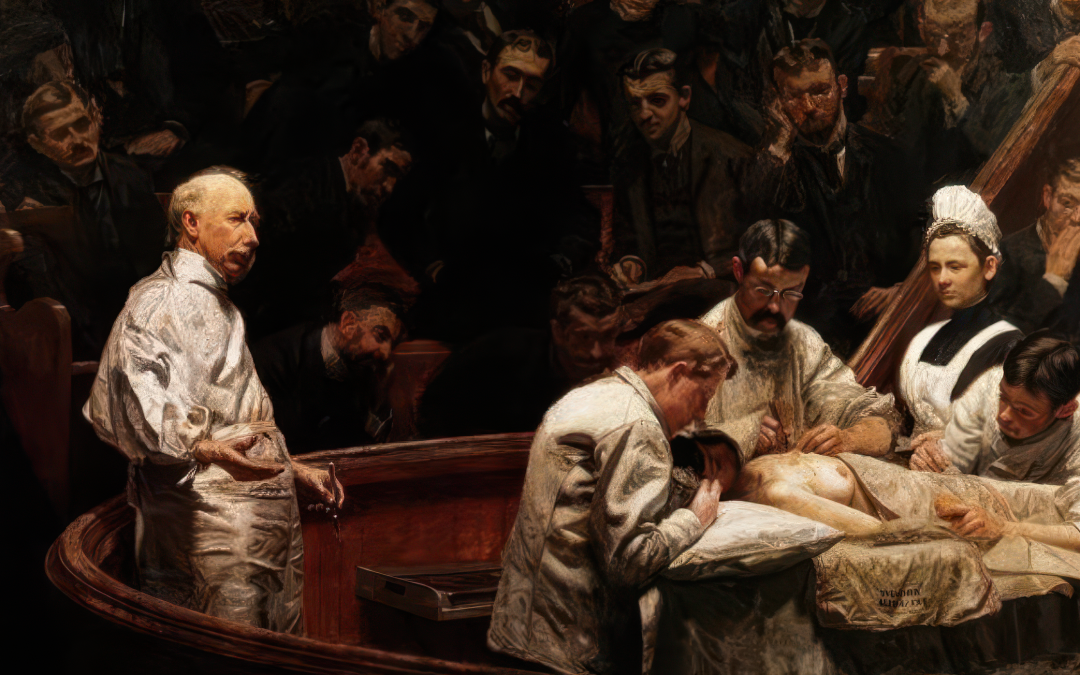

Imagine por un momento esa escena que ahora nos parece sacada de una película de terror: un cirujano preparándose para amputar una pierna gangrenada mientras varios hombres fornidos sujetan al paciente. El enfermo, completamente consciente, quizá mordiendo un trozo de cuero para no morderse la lengua, esperando con terror el primer corte. Los gritos que inevitablemente seguirían. El desmayo por el dolor, considerado una bendición por médicos y pacientes. Y después, si sobrevivía, el trauma psicológico permanente.

Esta era la medicina cotidiana que conocieron nuestros antepasados durante milenios. Y así seguiría siendo hoy, de no ser por una serie de descubrimientos y experimentaciones —algunas accidentales, otras metódicas— que ocurrieron principalmente en la década de 1840, un período que bien podríamos llamar la década milagrosa de la medicina.

En este artículo, exploraremos el fascinante recorrido de la anestesia desde sus primitivos orígenes hasta las sofisticadas técnicas actuales. Pero no nos limitaremos a una fría cronología de descubrimientos y fórmulas químicas. Indagaremos en el contexto social, cultural y filosófico que permitió estos avances, analizaremos las resistencias que enfrentaron y, sobre todo, reflexionaremos sobre cómo la capacidad de eliminar el dolor transformó no solo las prácticas médicas, sino nuestra relación con el sufrimiento, el cuerpo y la propia consciencia.

Esta es la historia de cómo la humanidad conquistó uno de sus más antiguos enemigos: el dolor. Y es también, en muchos sentidos, la historia de cómo la medicina dejó de ser una práctica temida para convertirse en una ciencia capaz de sanar sin añadir sufrimiento.

2. El dolor como compañero inevitable: métodos preanestésicos

2.1. Remedios antiguos: entre la ciencia y la superstición

En la antigua China, el cirujano Hua Tuo empleaba una preparación llamada mafeisan (posiblemente derivada del cannabis) para inducir insensibilidad durante procedimientos quirúrgicos ya en el siglo II. En India, el «vino de Morfeo», una mezcla de alcohol y diversas hierbas, servía para mitigar el dolor durante operaciones descritas en textos ayurvédicos.

La mandrágora, planta rodeada de mitos y supersticiones debido a la forma humanoide de su raíz, fue utilizada ampliamente en la Europa medieval. Dioscórides, en su «De Materia Medica» del siglo I, ya recomendaba su uso «cuando se quiere cortar o cauterizar». Los médicos árabes como Avicena refinaron estas preparaciones, creando «esponjas soporíferas» empapadas en soluciones de opio, mandrágora, beleño y otras plantas con propiedades sedantes.

Junto a estos métodos farmacológicos primitivos, existían procedimientos físicos igualmente rudimentarios: la compresión de nervios y arterias para adormecer miembros (técnica utilizada por los asirios), la aplicación de frío extremo (documentada por Hipócrates), o incluso provocar un traumatismo craneal controlado para inducir inconsciencia. Los cirujanos navales del siglo XVIII a veces golpeaban en la cabeza a los pacientes antes de amputaciones rápidas, un método tan desesperado como peligroso.

Estos intentos, aunque ingeniosos, resultaban impredecibles, insuficientes y frecuentemente peligrosos. El alcohol, quizás el más accesible de todos, podía proporcionar cierto alivio pero rara vez la insensibilidad necesaria para procedimientos mayores, además de complicar la recuperación.

2.2. La cirugía heroica: operar sin anestesia

Madrid, 1798. Un cirujano militar español se prepara para operar. Su paciente: un soldado con una herida de bala en la pierna que se ha infectado gravemente. La gangrena avanza y solo hay una opción: amputación. Cuatro robustos ayudantes sujetan al paciente. La operación debe ser rápida, preferiblemente en menos de tres minutos, antes de que el shock por dolor resulte fatal.

Esta escena, repetida miles de veces en hospitales, campos de batalla y hogares particulares, ilustra la brutalidad de la medicina preanestésica. Los cirujanos eran admirados no tanto por su precisión como por su velocidad y sangre fría. El cirujano francés Dominique Jean Larrey, médico personal de Napoleón, se hizo famoso por realizar 200 amputaciones en un solo día durante la Batalla de Borodino, a un ritmo aproximado de 15 minutos por procedimiento.

La figura del cirujano antes de la anestesia resultaba profundamente ambivalente: por un lado, era el salvador que podía extirpar lo enfermo para preservar la vida; por otro, era el torturador que infligía un dolor indescriptible, aunque fuera con intenciones benéficas. El propio cirujano debía desarrollar una impasibilidad ante el sufrimiento que hoy nos parecería inhumana, pero que entonces era requisito profesional. Como escribió el cirujano estadounidense Valentine Mott: «De todas las acciones que pueden degradar al hombre, ninguna es más cruel que la de aplicar el cuchillo a un compañero que sufre».

2.3. Los límites de la medicina preanestésica

La ausencia de anestesia efectiva imponía limitaciones severas a la medicina. Los procedimientos quirúrgicos se reducían principalmente a lo superficial y lo extremadamente necesario: amputaciones, extracción de cálculos, drenaje de abscesos y poco más. La cirugía abdominal o torácica resultaba prácticamente imposible, no solo por el dolor insoportable sino porque el paciente consciente no podía evitar moverse o contraer los músculos, complicando intervenciones que requerían precisión.

El tiempo operatorio constituía otra limitación crítica. Una cirugía debía completarse en minutos, no en horas. Robert Liston, famoso cirujano escocés del siglo XIX, se jactaba de poder amputar una pierna en menos de 30 segundos. Esta velocidad, aunque impresionante, inevitablemente sacrificaba precisión y cuidado.

Psicológicamente, el impacto resultaba devastador tanto para pacientes como para médicos. Muchos enfermos preferían morir antes que someterse al «remedio» quirúrgico. Los testimonios de la época describen pacientes que se suicidaban al saber que necesitaban cirugía, o que huían de los hospitales tras presenciar operaciones anteriores. Los cirujanos, por su parte, desarrollaban mecanismos psicológicos de defensa que a menudo derivaban en alcoholismo o trastornos mentales.

Incluso cuando un procedimiento quirúrgico resultaba técnicamente exitoso, las tasas de mortalidad eran enormes. El shock neurogénico producido por el dolor extremo mataba a muchos pacientes durante o inmediatamente después de la operación. Aquellos que sobrevivían quedaban frecuentemente traumatizados, con secuelas psicológicas que hoy reconoceríamos como trastorno de estrés postraumático.

En este contexto de limitaciones y sufrimiento, la búsqueda de métodos efectivos para eliminar el dolor durante procedimientos médicos no era simple comodidad o refinamiento, sino una necesidad urgente que podría transformar la práctica médica y salvar innumerables vidas.

3. El nacimiento de la anestesia moderna: los gloriosos años 1840

3.1. Los gases que cambiaron la historia: óxido nitroso y éter

La década de 1840 marca un antes y un después en la historia de la medicina, un período revolucionario donde confluyen dos líneas de investigación que cambiarían para siempre la práctica médica: los experimentos con óxido nitroso y éter.

Mientras tanto, el éter dietílico ((C₂H₅)₂O) seguía un camino similar. Conocido desde el siglo XIII y sintetizado por primera vez por el alquimista alemán Valerius Cordus en 1540, el éter se utilizaba principalmente como solvente y ocasionalmente como remedio para dolencias respiratorias. Sin embargo, a principios del siglo XIX, comenzó a ganar popularidad en círculos sociales como droga recreativa. Las «fiestas de éter» se hicieron comunes en ciertos ambientes, especialmente entre estudiantes de medicina, donde se inhalaban vapores para experimentar estados alterados de consciencia.

En este peculiar contexto donde ciencia, medicina y experimentación recreativa se entrecruzaban, surgieron las condiciones para el descubrimiento de las propiedades anestésicas de estas sustancias. Las «exhibiciones de gas hilarante«, populares en ferias y eventos sociales de la década de 1830 y 1840, consistían en que voluntarios inhalaban óxido nitroso para divertir al público con su comportamiento desinhibido. Fue precisamente en una de estas exhibiciones donde Horace Wells, un dentista de Hartford, Connecticut, observó algo revelador: un participante bajo los efectos del gas se golpeó fuertemente contra un banco, pero no mostró signos de dolor hasta que los efectos del gas se disiparon.

De manera similar, las propiedades del éter se revelaron gradualmente a través de una combinación de uso recreativo y observación científica. Estudiantes de medicina y jóvenes médicos que habían experimentado con éter notaron que producía insensibilidad más profunda y duradera que el óxido nitroso, aunque con efectos secundarios más pronunciados como náuseas y malestar posterior.

Estos gases, que habían sido objetos de curiosidad científica y diversión social, estaban a punto de transformarse en herramientas médicas revolucionarias en manos de pioneros que, combinando intuición, valentía y a veces simple buena suerte, darían el paso definitivo hacia la anestesia moderna.

3.2. Los pioneros y sus demostraciones

La historia de los pioneros de la anestesia está marcada por personajes fascinantes, descubrimientos simultáneos, controversias de prioridad y, en algunos casos, destinos trágicos. Tres figuras destacan en esta narrativa: Horace Wells, William T.G. Morton y Crawford W. Long.

Horace Wells (1815-1848), dentista de Hartford, Connecticut, fue el primero en intentar sistematizar el uso del óxido nitroso para procedimientos dentales. Tras su reveladora observación en una exhibición de gas hilarante en diciembre de 1844, Wells decidió experimentar en sí mismo. Al día siguiente, invitó al químico Gardner Quincy Colton, quien había dirigido la exhibición, a su consultorio. Allí, Wells inhaló el gas y pidió a un colega que le extrajera una muela. Al despertar, exclamó la frase que cambiaría la historia: «¡No sentí más que un pinchazo con una aguja!».

Entusiasmado por su descubrimiento, Wells viajó a Boston en enero de 1845 para realizar una demostración pública en el Hospital General de Massachusetts, ante estudiantes y el prestigioso cirujano John Collins Warren. Desafortunadamente, el paciente voluntario se quejó de dolor durante el procedimiento, provocando abucheos entre los asistentes, quienes consideraron la demostración un fraude. Este fracaso público devastó a Wells, quien eventualmente abandonó la odontología, cayó en el abuso de sustancias y, en un giro trágico, se suicidó en 1848 mientras estaba encarcelado por arrojar ácido a transeúntes durante un episodio psicótico.

William T.G. Morton (1819-1868), antiguo aprendiz de Wells, tomó un camino diferente. Tras experimentar con éter, que ofrecía una insensibilidad más profunda y duradera que el óxido nitroso, Morton realizó la primera demostración pública exitosa de anestesia quirúrgica el 16 de octubre de 1846, nuevamente en el Hospital General de Massachusetts. Esta fecha es considerada el «día del nacimiento de la anestesia». Morton administró éter a un paciente, Gilbert Abbott, permitiendo que el cirujano John Collins Warren extirpara sin dolor un tumor del cuello. Warren, impresionado, pronunció las palabras que resonarían en la historia de la medicina: «Caballeros, esto no es un engaño».

El éxito fue inmediato. La noticia se propagó rápidamente por Estados Unidos y Europa, y en cuestión de meses, cirujanos de todo el mundo comenzaron a utilizar éter en sus operaciones. Morton intentó patentar su preparado (que llamó «Letheon», aunque básicamente era éter con aromatizantes), pero la naturaleza del compuesto se hizo pronto evidente, y la ética médica de la época consideraba inapropiado restringir el acceso a un avance tan significativo. Morton pasó el resto de su vida luchando por el reconocimiento y compensación económica, muriendo arruinado en 1868.

Mientras tanto, Crawford W. Long (1815-1878), médico rural de Georgia, había estado utilizando éter en su práctica desde marzo de 1842, cuatro años antes que Morton. Long administró éter a un paciente, James Venable, para extirpar un quiste del cuello sin dolor. Repitió el procedimiento con éxito en varios pacientes, pero no publicó sus hallazgos hasta 1849, cuando ya Morton y otros habían recibido reconocimiento público. Aunque Long fue indudablemente el primero en usar éter como anestésico quirúrgico de manera deliberada y sistemática, su retraso en publicar le costó el lugar prominente que merecía en la historia oficial.

La controversia sobre quién debería recibir el crédito por el descubrimiento de la anestesia fue intensa y amarga, llegando incluso al Congreso de los Estados Unidos, que nunca resolvió definitivamente la cuestión. Hoy, la historia reconoce las contribuciones de estos tres pioneros, entendiendo que grandes descubrimientos raramente tienen un único autor, sino que emergen de un contexto donde múltiples mentes trabajan simultáneamente en problemas similares.

3.3. El cloroformo entra en escena

En noviembre de 1847, apenas un año después de la demostración de Morton, Simpson y dos de sus amigos realizaron un experimento que ya forma parte del folklore médico. Tras terminar una cena, los tres inhalaron vapores de un líquido recién sintetizado: el cloroformo. El resultado fue una rápida pérdida de consciencia de los tres participantes. Al despertar, Simpson quedó impresionado por la potencia y rapidez del efecto, así como por la ausencia del malestar típico asociado con el éter. Días después, utilizó cloroformo por primera vez en un parto, y pronto comenzó a emplearlo regularmente en su práctica obstétrica.

El cloroformo ofrecía varias ventajas sobre el éter: inducía anestesia más rápidamente, era más potente (requiriendo menor cantidad), no era inflamable (reduciendo el riesgo de incendios en una época de iluminación a gas o con velas) y tenía un olor menos irritante. Pronto se convirtió en el anestésico preferido en Europa, mientras que en Estados Unidos continuó predominando el éter.

Sin embargo, la adopción del cloroformo para anestesia obstétrica enfrentó una resistencia significativa, especialmente desde sectores religiosos que consideraban el dolor del parto como un castigo divino que no debía aliviarse. La Iglesia Anglicana y varios líderes religiosos denunciaron su uso como contrario a la voluntad de Dios, citando el pasaje bíblico: «Con dolor darás a luz a los hijos» (Génesis 3:16).

El punto de inflexión llegó en 1853, cuando el prestigioso médico John Snow administró cloroformo a la Reina Victoria durante el nacimiento de su octavo hijo, el Príncipe Leopoldo. La monarca quedó tan satisfecha con la experiencia que utilizó anestesia nuevamente en su último parto en 1857. Este respaldo real fue decisivo para la aceptación social de la anestesia obstétrica, neutralizando efectivamente las objeciones religiosas. El fenómeno incluso acuñó un término: «anestesia a la reina», que se popularizó entre las mujeres de clase alta europeas.

No obstante, el cloroformo no estaba exento de problemas. A diferencia del éter, que tiene un amplio margen de seguridad, el cloroformo puede causar arritmias cardíacas fatales y daño hepático. Las «muertes por cloroformo» comenzaron a documentarse, especialmente en casos donde se administraba sin la debida monitorización. Estas complicaciones eventualmente llevarían, décadas después, a su abandono como anestésico principal, pero durante la segunda mitad del siglo XIX, el cloroformo representó para millones de pacientes, especialmente mujeres en trabajo de parto, la primera posibilidad de experimentar procedimientos médicos sin el tormento del dolor.

4. Entre la resistencia y la aceptación: debates sobre la anestesia

4.1. «Contra natura»: objeciones religiosas y filosóficas

El descubrimiento de la anestesia, aunque revolucionario desde la perspectiva médica, chocó frontalmente con arraigadas concepciones religiosas, filosóficas y culturales sobre el dolor y el sufrimiento. Para muchos contemporáneos, la idea de «apagar» artificialmente la consciencia y eliminar el dolor no solo parecía antinatural sino potencialmente pecaminosa o moralmente peligrosa.

En círculos religiosos, especialmente protestantes y católicos conservadores, el dolor era interpretado como un componente esencial de la condición humana tras la caída de Adán y Eva. El sufrimiento físico se entendía como un castigo divino, una prueba moral o incluso una oportunidad de redención. Eliminar el dolor mediante productos químicos parecía una interferencia impropia con el plan divino. Como argumentó el reverendo Thomas Chalmers, influyente teólogo escocés: «El dolor es el guardián de la existencia humana designado por la Providencia Divina. Evitarlo artificialmente equivale a rechazar la sabiduría del Creador».

Particularmente controvertido resultó el uso de anestesia en el parto, como veremos en detalle más adelante. La interpretación literal del pasaje bíblico «con dolor darás a luz a los hijos» (Génesis 3:16) llevó a muchos líderes religiosos a oponerse vehementemente a la anestesia obstétrica, considerándola una transgresión directa del mandato divino.

Desde perspectivas filosóficas, también surgieron objeciones significativas. La corriente vitalista, todavía influyente en la primera mitad del siglo XIX, consideraba que los seres vivos poseían una «fuerza vital» o «principio vital» que los diferenciaba fundamentalmente de la materia inanimada. La anestesia, que aparentemente «apagaba» temporalmente esta fuerza vital sin extinguirla por completo, representaba un misterioso estado intermedio que desafiaba las categorías establecidas entre consciencia e inconsciencia, vida y muerte.

Filósofos y médicos de orientación romántica expresaron preocupaciones sobre la «deshumanización» que podría acarrear la eliminación del dolor. El médico y filósofo alemán Carl Gustav Carus argumentó que «el dolor, aunque desagradable, constituye una expresión fundamental de nuestra humanidad. Silenciarlo químicamente significa alienar al paciente de su propia experiencia corporal».

Incluso surgieron argumentos que conectaban la anestesia con prácticas «diabólicas» o «mágicas». No es casualidad que en su defensa del cloroformo obstétrico, James Simpson recurriera a argumentos bíblicos, señalando que el primer uso de anestesia registrado en la Biblia fue cuando «Dios hizo caer un sueño profundo sobre Adán» para extraer la costilla de la que formaría a Eva” (Génesis 2:21).

Estas resistencias, aunque pueden parecer irracionales desde nuestra perspectiva contemporánea, revelan el profundo impacto cultural y filosófico que supuso la introducción de la anestesia. El poder eliminar artificialmente la consciencia y el dolor no solo transformó las prácticas médicas, sino que obligó a reconsiderar ideas fundamentales sobre la naturaleza humana, el sufrimiento y los límites de la intervención científica en procesos naturales.

4.2. La controversia obstétrica: ¿debe la mujer parir con dolor?

La aplicación de la anestesia al parto generó quizás la controversia más intensa de todas, evidenciando una compleja intersección entre medicina, religión y concepciones sociales sobre la mujer y la maternidad. El empleo de éter y posteriormente cloroformo durante el trabajo de parto enfrentó resistencias particularmente feroces que revelaban profundos presupuestos culturales.

La objeción religiosa fundamental, como ya mencionamos, derivaba de la interpretación literal del castigo divino a Eva en Génesis 3:16: «Multiplicaré tus dolores en el parto, y con dolor darás a luz a tus hijos». Para numerosos teólogos y clérigos, aliviar este dolor mediante anestesia constituía una rebelión directa contra la voluntad divina. El reverendo Charles Meigs, influyente obstetra y profesor estadounidense, sintetizó esta postura declarando: «Los sufrimientos durante el parto constituyen un perfecto componente fisiológico del proceso. ¿Acaso debemos pretender ser más sabios que Dios?».

Además de las objeciones teológicas, emergieron argumentos pseudo-científicos específicamente dirigidos contra la anestesia obstétrica. Algunos médicos sostenían que el dolor durante el parto cumplía funciones fisiológicas necesarias: estimulaba contracciones más efectivas, preparaba psicológicamente a la madre para la crianza, o incluso fortalecía el vínculo materno-infantil. Otros advertían sobre supuestos efectos nocivos del éter o cloroformo sobre el feto, o sobre una presunta «feminización» de los bebés nacidos sin el «fortalecedor» trance del dolor.

Subyacente a muchas de estas objeciones se encontraba una concepción cultural profundamente arraigada: la idea de que el sufrimiento en el parto constituía un rito de paso necesario hacia la maternidad plena, una prueba de virtud femenina. Como expresó un editorial médico de 1848: «Hay algo noble en la mujer que soporta estoicamente los dolores que la convierten en madre. La anestesia obstétrica amenaza con producir una generación de madres que nunca han demostrado este coraje fundamental».

Frente a estas resistencias, destacó la figura del ya mencionado James Young Simpson, quien defendió apasionadamente la anestesia obstétrica desde múltiples frentes. A los argumentos religiosos respondió con su propia exégesis bíblica, señalando que la Biblia nunca prohíbe aliviar las consecuencias del pecado original (como evidencian los avances médicos para tratar enfermedades). A las objeciones médicas contrapuso evidencia clínica sobre los beneficios de la anestesia: reducción del shock, menor agotamiento materno y disminución de complicaciones.

Significativamente, las primeras defensoras de la anestesia obstétrica fueron frecuentemente mujeres de clase media-alta, quienes reclamaban su derecho a decidir sobre sus propios cuerpos. Elizabeth Cady Stanton, pionera feminista estadounidense, vinculó explícitamente el acceso a la anestesia obstétrica con la emancipación femenina, argumentando que la imposición del dolor evitable representaba una forma más de opresión patriarcal.

El punto de inflexión en este debate, como ya mencionamos, llegó en 1853 cuando la Reina Victoria utilizó cloroformo durante el nacimiento del Príncipe Leopoldo, administrado por John Snow. El respaldo de la monarca, cabeza de la Iglesia Anglicana, neutralizó efectivamente las objeciones religiosas más estridentes. Como comentó irónicamente un periódico de la época: «Si la anestesia obstétrica es suficientemente buena para la Reina de Inglaterra, probablemente sea aceptable para el resto de las mujeres».

En las décadas siguientes, la anestesia en el parto se fue normalizando gradualmente, aunque persistieron resistencias significativas. La controversia obstétrica ilustra vívidamente cómo las innovaciones médicas no ocurren en un vacío técnico o científico, sino que se insertan en complejas tramas de significados sociales, religiosos y culturales que pueden facilitar o dificultar su adopción.

4.3. Preocupaciones médicas legítimas

Más allá de las objeciones filosóficas y religiosas, existieron genuinas preocupaciones médicas sobre la seguridad y efectos secundarios de los primeros anestésicos. Estas reservas, basadas en observaciones clínicas y no en prejuicios, merecen consideración especial, pues reflejan los verdaderos desafíos que enfrentaron los pioneros de la anestesia.

La muerte de Hannah Greener en 1848

Los primeros años tras la introducción del éter y el cloroformo estuvieron marcados por una inquietante serie de muertes y complicaciones graves. En enero de 1848, apenas quince meses después de la primera demostración pública exitosa, una joven llamada Hannah Greener murió en Inglaterra mientras recibía cloroformo para la extracción de una uña encarnada. Esta muerte, ampliamente publicada, generó alarma considerable en la comunidad médica y el público general.

El cloroformo resultó particularmente problemático. A diferencia del éter, que tiene un amplio margen de seguridad (la dosis que causa depresión respiratoria es considerablemente mayor que la necesaria para anestesia), el cloroformo puede provocar arritmias cardíacas fatales con dosis apenas superiores a las terapéuticas. Además, se documentaron casos de hepatitis tóxica post-anestésica, especialmente en pacientes sometidos a múltiples administraciones.

El éter, aunque menos letal, presentaba sus propios inconvenientes: alta inflamabilidad (causante de varios incendios y explosiones en quirófanos iluminados con lámparas de gas), irritación de las vías respiratorias que provocaba tos y aumento de secreciones, y frecuentes náuseas y vómitos postoperatorios. Además, su administración resultaba técnicamente complicada: requería grandes cantidades, inducía la anestesia lentamente y producía una fase de excitación inicial que podía ser problemática.

La administración de estos primeros anestésicos constituía más un arte que una ciencia exacta. Sin dispositivos de monitorización modernos, los anestesistas dependían principalmente de signos clínicos como el patrón respiratorio, el pulso, el color de la piel y el tamaño pupilar para evaluar la profundidad anestésica. El Dr. John Snow, primer médico en dedicarse exclusivamente a la anestesia, describió cinco etapas de la anestesia con éter, pero la línea entre anestesia adecuada y sobredosis potencialmente fatal era difícil de determinar con precisión.

Igualmente preocupante resultaba la ausencia de estandarización en los equipos y técnicas. Los primeros aparatos para administrar anestésicos eran rudimentarios y variaban considerablemente: desde simples paños empapados colocados sobre la cara del paciente hasta complejos inhaladores diseñados por médicos individuales. Esta variabilidad dificultaba el establecimiento de pautas seguras y reproducibles.

Otra preocupación legítima concernía los efectos a largo plazo. En una época anterior a los estudios toxicológicos modernos, los médicos observaron con inquietud secuelas como daño hepático, renal o neurológico en algunos pacientes. También surgieron interrogantes sobre posibles efectos adictivos, especialmente relevantes considerando el origen recreativo del uso del éter y el óxido nitroso.

Frente a estas complicaciones reales, la comunidad médica respondió con un notable esfuerzo colectivo para mejorar la seguridad anestésica. Se crearon comisiones de investigación para estudiar las muertes anestésicas (como la «Comisión sobre Cloroformo» de la Royal Medical and Chirurgical Society británica). Se desarrollaron métodos de administración más controlados, como los inhaladores de Snow para cloroformo, que permitían regular la concentración del vapor. Se establecieron las primeras pautas para la selección de pacientes y la preparación preanestésica.

Estas preocupaciones y esfuerzos tempranos por mejorar la seguridad sentaron las bases para el desarrollo posterior de la anestesiología como especialidad médica rigurosa y científica, demostrando que el entusiasmo por el nuevo descubrimiento no impidió una evaluación crítica y responsable de sus riesgos.

5. La profesionalización de la anestesia

5.1. Del aficionado al especialista

Los primeros anestésicos fueron administrados por un variopinto grupo de individuos: cirujanos que delegaban brevemente la operación a un asistente para anestesiar al paciente, estudiantes de medicina con escasa formación, e incluso personal no médico como porteros de hospital o familiares del paciente. Esta situación, comprensible en los días iniciales de la anestesia, pronto reveló sus peligros. La administración de sustancias potencialmente letales requería conocimientos, experiencia y dedicación específicos.

John Snow (1813-1858) emerge como la figura pionera en la profesionalización de la anestesia. Médico londinense conocido por sus investigaciones sobre el cólera, Snow desarrolló un interés inmediato por la anestesia tras las noticias llegadas de Estados Unidos. A diferencia de muchos contemporáneos que veían la administración anestésica como una tarea secundaria, Snow la convirtió en el centro de su práctica médica. Estudió meticulosamente las propiedades físicas y farmacológicas del éter y cloroformo, desarrolló inhaladores que permitían regular la concentración del vapor anestésico, y estableció protocolos basados en observaciones sistemáticas.

Snow mantenía registros detallados de cada administración anestésica, documentando técnica, dosis, respuesta del paciente y complicaciones. Esta aproximación científica al problema le permitió describir las etapas de la anestesia y establecer pautas de seguridad. Su prestigio culminó cuando fue seleccionado para administrar cloroformo a la Reina Victoria durante sus partos de 1853 y 1857.

En Estados Unidos, la profesionalización siguió un camino diferente. Resultaba económicamente inviable dedicarse exclusivamente a la anestesia, por lo que emergió un modelo alternativo: la enfermera anestesista. Durante la Guerra Civil Americana (1861-1865), las hermanas de la Caridad y otras enfermeras comenzaron a especializarse en la administración de anestésicos, desarrollando considerable experiencia práctica. Esta tradición continuó después de la guerra, consolidándose con figuras como Alice Magaw, quien trabajó con los hermanos Mayo y publicó importantes artículos sobre técnicas anestésicas seguras a principios del siglo XX.

En 1889, se estableció en Alemania la primera cátedra universitaria dedicada a la anestesia, ocupada por Johann Friedrich August von Esmarch. En Inglaterra, Joseph Thomas Clover desarrolló importantes avances técnicos como el «aparato Clover» para cloroformo en 1862. Sin embargo, la verdadera institucionalización de la anestesia como especialidad médica independiente no ocurriría hasta principios del siglo XX.

El proceso de profesionalización reflejó tensiones sociales y de género significativas. En Estados Unidos, se desarrolló una dicotomía duradera entre el modelo médico (anestesiólogo) y el modelo de enfermería (enfermera anestesista). Esta división, parcialmente basada en jerarquías de género, generó conflictos que persisten hasta hoy. En contraste, en el Reino Unido y gran parte de Europa continental, la anestesia se estableció firmemente como especialidad médica desde el principio.

La Primera Guerra Mundial aceleró la profesionalización, demostrando la crucial importancia de anestesistas bien formados para la cirugía de guerra. Las elevadas tasas de mortalidad asociadas con anestesia improvisada en el frente contrastaban dramáticamente con los resultados obtenidos por equipos quirúrgicos con anestesistas especializados.

Para la década de 1940, la mayoría de países occidentales habían establecido programas formales de formación en anestesiología, exámenes de certificación y estructuras académicas dedicadas. La transformación había sido completa: de práctica improvisada realizada por aficionados, la administración anestésica se convirtió en una disciplina científica con corpus teórico propio, metodología específica y profesionales dedicados exclusivamente a su estudio y aplicación.

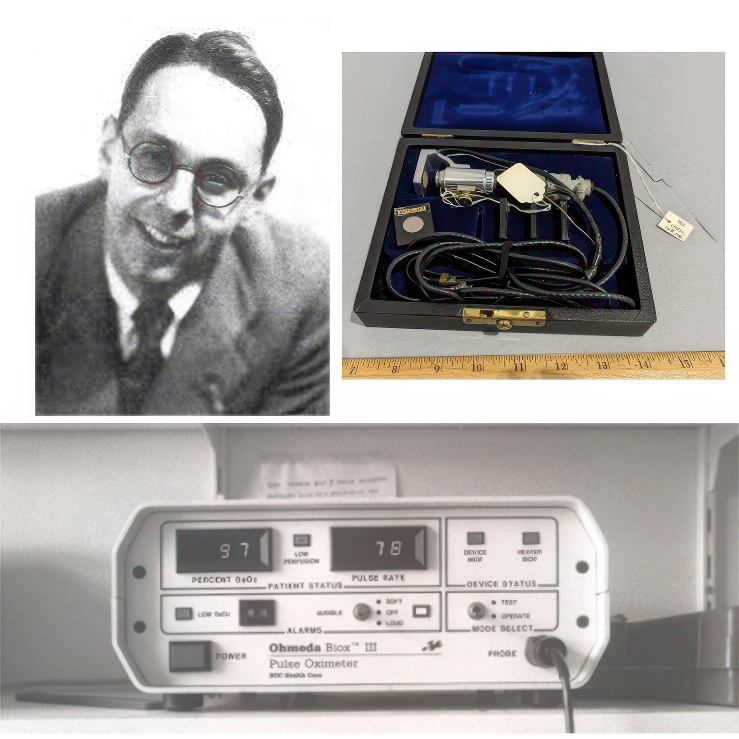

5.2. Equipamiento y monitorización: la tecnificación del proceso

Paralelamente a la profesionalización de la anestesia, se produjo una notable evolución tecnológica que transformó profundamente la práctica anestésica. Desde los rudimentarios paños empapados en éter hasta los sofisticados equipos del siglo XX, este desarrollo técnico reflejó la creciente complejidad y seguridad de la anestesia moderna.

Los primeros dispositivos para administrar anestésicos inhalados eran sorprendentemente simples. Morton utilizó un globo de vidrio modificado con una válvula que permitía inhalar los vapores de éter. Simpson administraba cloroformo vertiendo unas gotas en un pañuelo que colocaba sobre la cara del paciente. Estos métodos primitivos no permitían controlar la concentración del anestésico, resultando en frecuentes casos de sobredosis o anestesia insuficiente.

John Snow dio el primer paso crucial hacia la tecnificación con su inhalador de éter (1847) y posteriormente su inhalador de cloroformo (1848). Estos dispositivos, aunque todavía rudimentarios para estándares actuales, representaron el primer intento de controlar científicamente la concentración de vapor anestésico administrado. El inhalador de cloroformo de Snow, con su sistema de dilución de vapor, redujo significativamente el riesgo de sobredosis letales.

Joseph Thomas Clover continuó esta línea de innovación, desarrollando en 1862 su famoso «aparato Clover» para cloroformo, que incorporaba un sistema de reinhalación parcial y permitía un control más preciso de la dosificación. Posteriormente, en 1877, creó un aparato portátil para administrar óxido nitroso con oxígeno, una combinación que reducía considerablemente los riesgos de hipoxia asociados al óxido nitroso puro.

Un avance fundamental ocurrió en 1917, cuando Henry Edmund Gaskin Boyle introdujo el «aparato Boyle», basado en diseños americanos previos. Este sistema, que combinaba flujómetros precisos y vaporizadores calibrados, permitía administrar mezclas controladas de gases anestésicos y oxígeno. Con sus modificaciones posteriores, el aparato Boyle se convirtió en el estándar para la anestesia por inhalación durante décadas.

La monitorización del paciente anestesiado también experimentó una evolución notable. En los primeros días, los anestesistas dependían exclusivamente de signos clínicos básicos: observación del patrón respiratorio, palpación del pulso, color de piel y mucosas, tamaño y reactividad pupilar. Con el tiempo, se incorporaron instrumentos de medición cada vez más sofisticados.

La introducción del estetoscopio precordial por Harvey Cushing en 1908 permitió la auscultación continua de los ruidos cardíacos y respiratorios durante la anestesia. La adopción del esfigmomanómetro para medición no invasiva de la presión arterial añadió otro parámetro cuantificable. Para la década de 1930, en quirófanos avanzados se monitorizaba rutinariamente presión arterial, pulso y respiración, aunque todavía de manera intermitente y manual.

Paralelamente, los sistemas de administración anestésica evolucionaron hacia máquinas cada vez más complejas pero también más seguras. Se incorporaron sistemas de alarma para detectar desconexiones o presiones anómalas en el circuito, válvulas de sobrepresión para prevenir barotrauma pulmonar, y analizadores de gases que permitían monitorizar las concentraciones exactas de anestésicos inhalados y gases respiratorios.

La introducción de ventiladores mecánicos específicamente diseñados para anestesia, a partir de la década de 1950, permitió controlar con precisión la ventilación del paciente durante procedimientos prolongados. Esto, junto con el desarrollo de bloqueantes neuromusculares modernos, facilitó el auge de cirugías torácicas y abdominales mayores que requerían relajación muscular profunda y ventilación controlada.

Esta tecnificación progresiva transformó el quirófano moderno en un entorno altamente especializado, donde el anestesiólogo gestiona sistemas complejos que administran fármacos precisamente dosificados mientras monitorizan múltiples parámetros fisiológicos. Lejos quedaban los días en que un paño empapado en éter y la observación del color de la piel eran las únicas herramientas disponibles.

6. La revolución farmacológica: nuevos anestésicos

6.1. De los gases a los inyectables

Durante casi un siglo después del descubrimiento de la anestesia, los agentes inhalados (éter, cloroformo y posteriormente ciclopropano y halotano) dominaron el panorama anestésico. Sin embargo, paralelamente se desarrollaba una revolución silenciosa que transformaría profundamente la práctica: el advenimiento de los anestésicos intravenosos.

Los primeros intentos de anestesia intravenosa se remontan a 1872, cuando Pierre-Cyprien Oré en Francia utilizó hidrato de cloral para producir anestesia quirúrgica. Sin embargo, este y otros experimentos tempranos resultaron inconsistentes y frecuentemente peligrosos. El verdadero punto de inflexión llegó en 1932, cuando John Lundy en la Clínica Mayo introdujo el tiopental sódico (Pentothal) en la práctica clínica.

El tiopental, un barbitúrico de acción ultrarrápida, revolucionó la inducción anestésica. Por primera vez, los pacientes podían «dormirse» en cuestión de segundos tras una inyección intravenosa, evitando la fase de excitación y la sensación desagradable asociadas con la inhalación de éter o cloroformo. La elegancia y rapidez de esta inducción contrastaba dramáticamente con los minutos de inhalación forzada requeridos previamente.

La Segunda Guerra Mundial aceleró la adopción del tiopental. Su facilidad de administración en condiciones de campo y la rápida recuperación que permitía resultaban ideales para cirugía de guerra. Sin embargo, la experiencia bélica también reveló sus limitaciones: en pacientes hipovolémicos por hemorragia, el tiopental podía provocar colapso cardiovascular catastrófico, como se observó trágicamente en Pearl Harbor.

El tiopental y otros barbitúricos presentaban una limitación fundamental: aunque excelentes para la inducción, resultaban inadecuados para mantener la anestesia durante procedimientos prolongados debido a su acumulación y recuperación impredecible. La solución surgió con el desarrollo de técnicas de anestesia «equid9ibrada» o «combinada», donde la inducción con barbitúricos se complementaba con anestésicos inhalados, opioides y relajantes musculares para el mantenimiento.

La siguiente revolución en anestesia intravenosa llegó en 1977 con la introducción clínica del propofol. Este fármaco no barbitúrico ofrecía ventajas significativas: recuperación extraordinariamente rápida incluso tras infusiones prolongadas, mínima acumulación tisular, y menores efectos secundarios (especialmente menor depresión respiratoria y cardiovascular). El característico color blanco lechoso del propofol, debido a su formulación en emulsión lipídica, se convirtió en imagen emblemática de la anestesia moderna.

El propofol transformó la anestesia ambulatoria y los procedimientos diagnósticos breves. Pacientes que recibían propofol para endoscopias o cirugías menores podían despertar lúcidos y orientados minutos después de finalizado el procedimiento, con mínima sedación residual y náuseas postoperatorias casi inexistentes. Esto permitió el auge de centros quirúrgicos ambulatorios y redujo dramáticamente las estancias hospitalarias.

Paralelamente, evolucionaron los anestésicos inhalados. El éter y cloroformo fueron gradualmente reemplazados por agentes más seguros: ciclopropano en los años 1930-40, halotano en los 1950-60, y finalmente los modernos anestésicos halogenados (enflurano, isoflurano, sevoflurano y desflurano) a partir de los 1970. Estos nuevos agentes ofrecían mayor seguridad, menor irritación respiratoria, y metabolismo mínimo que reducía la toxicidad hepática y renal.

La verdadera revolución conceptual ocurrió en los años 1990 con el desarrollo de la Anestesia Total Intravenosa (TIVA). Mediante bombas de infusión controladas por computadora y modelos farmacocinéticos sofisticados, se podía mantener concentraciones estables de propofol y otros agentes intravenosos sin necesidad de anestésicos inhalados. La TIVA ofreció ventajas significativas en ciertos escenarios: cirugía de vía aérea, neurocirugía, y pacientes susceptibles a náuseas postoperatorias o hipertermia maligna.

Para principios del siglo XXI, el anestesiólogo disponía de un arsenal farmacológico sofisticado que permitía aproximaciones personalizadas: desde la tradicional anestesia inhalatoria hasta la TIVA, o combinaciones según las necesidades específicas del paciente y procedimiento. Esta flexibilidad, impensable para los pioneros que trabajaban con éter y cloroformo, representa uno de los mayores logros de la farmacología anestésica moderna.

6.2. Anestesia local y regional: cuando solo una parte «duerme»

Las últimas décadas han presenciado una renaissance de la anestesia regional, impulsada por dos innovaciones tecnológicas fundamentales: la neuroestimulación y la ultrasonografía. Los neuroestimuladores, popularizados en los 1980s, permitieron localizar nervios periféricos con mayor precisión mediante respuestas motoras a pequeñas corrientes eléctricas. La guía ecográfica, adoptada ampliamente desde los 2000s, revolucionó aún más la precisión, permitiendo visualización directa de estructuras nerviosas, distribución del anestésico, y monitorización en tiempo real del procedimiento.

Esta evolución histórica ha posicionado la anestesia regional como componente indispensable de la práctica anestésica contemporánea. Procedimientos que rutinariamente requerían anestesia general—desde reparaciones de hernia hasta artroplastias de rodilla—se realizan ahora frecuentemente bajo técnicas regionales, ofreciendo ventajas significativas: menor impacto fisiológico, recuperación más rápida, analgesia postoperatoria superior y reducción de complicaciones como náuseas, vómitos y disfunción cognitiva postoperatoria. Esta modalidad, nacida de la observación casual de un joven oftalmólogo, ha evolucionado hasta representar uno de los pilares fundamentales de la anestesiología moderna.

7. La anestesia y la transformación de la cirugía

7.1. Más allá de lo imposible: nuevos horizontes quirúrgicos

La relación entre anestesia y cirugía puede describirse como una simbiosis perfecta: cada avance en una disciplina ha posibilitado y estimulado el desarrollo de la otra. Si la anestesia liberó a la cirugía de las restricciones impuestas por el dolor y la consciencia del paciente, los nuevos procedimientos quirúrgicos motivaron el desarrollo de técnicas anestésicas cada vez más sofisticadas y seguras.

Antes de la anestesia moderna, las intervenciones quirúrgicas estaban severamente limitadas. La cirugía preanestésica se reducía principalmente a tres categorías: procedimientos superficiales (abscesos, pequeños tumores), amputaciones, y unas pocas operaciones desesperadas como trepanaciones o litotomías. Cualquier procedimiento debía completarse en minutos, literalmente a contrarreloj. Las cavidades corporales permanecían prácticamente inviolables: abrir el tórax o el abdomen garantizaba no solo dolor insoportable sino también movimientos involuntarios que hacían imposible cualquier trabajo quirúrgico preciso.

La introducción de la anestesia eliminó estas restricciones fundamentales. De repente, los cirujanos disponían de tiempo: una operación podía durar no minutos sino horas si era necesario. El campo quirúrgico permanecía inmóvil, permitiendo precisión inimaginable previamente. Y lo más revolucionario: las cavidades corporales podían explorarse sistemáticamente, inaugurando la era de la cirugía interna.

La primera especialidad en beneficiarse dramáticamente fue la cirugía abdominal. Apenas un año después de la demostración de Morton, cirujanos como James Marion Sims comenzaron a realizar sistemáticamente operaciones ginecológicas bajo anestesia. En 1846, John Collins Warren extirpó un tumor abdominal durante un procedimiento que duró 25 minutos—tiempo impensable sin anestesia. Para 1880, Theodor Billroth había realizado la primera gastrectomía exitosa por cáncer, inaugurando la cirugía oncológica moderna. La cirugía abdominal floreció espectacularmente: apendicectomías, colecistectomías, reparaciones de hernias, histerectomías—procedimientos que hoy consideramos rutinarios pero que resultaban virtualmente imposibles antes de la anestesia.

La cirugía torácica enfrentaba un desafío adicional: cuando se abría la cavidad pleural, el pulmón colapsaba por la presión atmosférica, causando insuficiencia respiratoria potencialmente fatal. La solución llegó con el desarrollo de la intubación endotraqueal y la ventilación con presión positiva. Aunque la intubación traqueal se había realizado ocasionalmente desde el siglo XVIII, solo con la introducción del laringoscopio por Alfred Kirstein en 1895 y posteriormente los trabajos de Chevalier Jackson se convirtió en procedimiento sistemático. Franz Kuhn realizó las primeras intubaciones para anestesia en 1900-1901, y Magill y Rowbotham refinaron las técnicas durante la Primera Guerra Mundial. Estas innovaciones permitieron mantener la ventilación durante cirugía torácica, posibilitando procedimientos como lobectomías, neumonectomías y eventualmente cirugía cardíaca.

La neurocirugía experimentó un desarrollo paralelo. Harvey Cushing, trabajando en Johns Hopkins a principios del siglo XX, estableció los principios fundamentales de la anestesia neuroquirúrgica, enfatizando la ventilación controlada, monitorización cuidadosa de signos vitales, y posicionamiento preciso. Estos avances, combinados con técnicas de diagnóstico neurológico mejoradas, permitieron abordar tumores cerebrales, malformaciones vasculares y traumatismos que anteriormente resultaban letales.

La cirugía cardíaca representó quizás el horizonte más desafiante. Operar en un órgano en movimiento, cuya función no podía interrumpirse sin causar muerte inmediata, parecía imposible incluso con anestesia. Los primeros avances llegaron con reparaciones «a ciegas» de estenosis mitral por Cutler y Levine en 1923, y suturas de heridas cardíacas por Rehn. El verdadero punto de inflexión ocurrió con el desarrollo de técnicas de circulación extracorpórea. John Gibbon realizó la primera cirugía a corazón abierto con bypass cardiopulmonar en 1953, inaugurando la era moderna de cirugía cardíaca. Este logro requirió avances paralelos en anestesia: manejo hemodinámico sofisticado, anticoagulación controlada, monitorización invasiva compleja, y técnicas de protección miocárdica y cerebral.

Los trasplantes de órganos, quizás el ejemplo más emblemático de la cirugía moderna, dependieron igualmente de avances anestésicos específicos. El primer trasplante renal exitoso, realizado por Joseph Murray en 1954, requirió protocolos anestésicos que mantuvieran perfusión renal óptima mientras se minimizaba el daño de reperfusión. El histórico trasplante cardíaco de Christiaan Barnard en 1967 necesitó técnicas para manejar la disfunción del injerto y las complicaciones hemodinámicas específicas de estos procedimientos.

Cada una de estas fronteras quirúrgicas superadas motivó y requirió innovaciones anestésicas correspondientes: nuevos fármacos, técnicas de monitorización avanzada, protocolos de ventilación sofisticados, estrategias de manejo hemodinámico, métodos de anticoagulación controlada, y aproximaciones específicas para protección de órganos. La especialización progresiva de la cirugía estimuló la subespecialización en anestesia: neuroanestesia, anestesia cardiotorácica, anestesia pediátrica, anestesia para trasplantes—cada una con su cuerpo de conocimientos y habilidades específicas.

Esta relación simbiótica continúa hasta hoy. Procedimientos mínimamente invasivos como laparoscopias y toracoscopias han motivado técnicas anestésicas adaptadas a sus particulares desafíos fisiológicos. La cirugía robótica, con sus posiciones extremas y tiempos operatorios prolongados, ha estimulado innovaciones en manejo de vía aérea, posicionamiento y prevención de complicaciones específicas. Los avances en neuroimagen funcional intraoperatoria han inspirado técnicas de anestesia que preservan la integridad de señales electrofisiológicas mientras mantienen adecuada profundidad anestésica.

La historia de esta relación entre anestesia y cirugía demuestra que los avances médicos más significativos raramente ocurren en aislamiento. La conquista de nuevos horizontes quirúrgicos ha sido posible gracias a la evolución paralela y sinérgica de la anestesiología, una especialidad nacida precisamente para hacer posible lo que antes se consideraba imposible.

7.2. La humanización del quirófano

Más allá de posibilitar avances técnicos, la anestesia transformó profundamente la experiencia humana de la cirugía. Este cambio, aunque menos cuantificable que las innovaciones quirúrgicas, representa quizás el impacto más significativo en términos de experiencia paciente y perspectivas socioculturales sobre la medicina.

Antes de la anestesia, el quirófano constituía un escenario casi dantesco. Los pacientes, plenamente conscientes, experimentaban terror anticipatorio mientras esperaban su turno, escuchando los gritos de quienes les precedían. Durante la intervención, el dolor extremo provocaba respuestas que oscilaban entre la resistencia violenta y la resignación estoica. Los cirujanos, por necesidad, desarrollaban una insensibilidad al sufrimiento que hoy consideraríamos perturbadora. Como escribió el cirujano francés Velpeau en 1839: «Evitar el dolor en operaciones es una quimera que hoy no podemos perseguir… El instrumento cortante y el dolor en operaciones son dos palabras que nunca se separarán en la mente de los pacientes, y esta necesaria asociación debe ser aceptada por los cirujanos».

El primer y más obvio cambio que aportó la anestesia fue eliminar el dolor quirúrgico. Como observó Jacob Bigelow después de presenciar la demostración de Morton: «He visto algo hoy que recorrerá el mundo». Pacientes que previamente habrían enfrentado procedimientos con terror insoportable, podían ahora someterse a cirugía con relativa tranquilidad psicológica. La transformación fue tan profunda que reorganizó completamente la relación médico-paciente en el ámbito quirúrgico.

Esta nueva realidad humanizó primero al paciente. Liberado del dolor y la consciencia durante la intervención, el enfermo dejó de ser un cuerpo resistente que dominar, convirtiéndose en una persona a cuidar. La evolución desde la sujeción forzosa hasta el actual posicionamiento meticulosamente cuidadoso ejemplifica este cambio. Donde antes se necesitaban ayudantes fuertes para controlar movimientos desesperados, ahora un equipo multidisciplinar monitoriza y protege al paciente inconsciente, previendo cada posible complicación.

Paralelamente, se humanizó también al cirujano. Liberado de la terrible responsabilidad de infligir dolor, aunque fuera con fines terapéuticos, el cirujano pudo desarrollar una aproximación más compasiva y menos disociativa. La frase atribuida a William Halsted resulta reveladora: «El cirujano que pretende ser artista sin ser científico se convierte en criminal». La anestesia permitió que la cirugía transitara desde el ámbito de la velocidad necesaria hacia el ideal de la precisión meticulosa, revalorando cualidades como paciencia, delicadeza y perfeccionismo técnico.

La dinámica completa del quirófano se transformó. El ambiente de confrontación forzosa entre equipo quirúrgico y paciente resistente dio paso a una colaboración estructurada donde anestesista, cirujano y personal de enfermería trabajaban coordinadamente mientras el paciente «dormía». Esta nueva configuración posibilitó incluso transformaciones arquitectónicas del espacio quirúrgico: de los anfiteatros abiertos diseñados para exhibir la velocidad y destreza del cirujano frente a audiencias, a los modernos quirófanos cerrados, aislados y técnicamente sofisticados diseñados para optimizar seguridad y eficiencia.

La transformación cultural fue igualmente profunda. La cirugía preanestésica ocupaba en el imaginario público un lugar cercano a la tortura necesaria—un mal menor aceptado solo frente a alternativas peores. La anestesia permitió reconcebir la intervención quirúrgica como experiencia de curación sin sufrimiento, como lo expresó Oliver Wendell Holmes en 1847 al acuñar el término «anestesia»: «Este estado podría llamarse ‘anestesia’ [del griego «sin sensación»]… creo que sería mejor que ‘narcotismo’ y otras propuestas derivadas, que tienen implicaciones desagradables».

Este cambio conceptual impactó la disposición de los pacientes a considerar tratamientos quirúrgicos. Procedimientos que anteriormente se posponían indefinidamente por miedo, ahora podían plantearse como opciones terapéuticas razonables. La cirugía preventiva o electiva, prácticamente inexistente en la era preanestésica, se desarrolló gradualmente gracias a esta transformación actitudinal.

La educación médica y quirúrgica también experimentó cambios fundamentales. La anestesia facilitó un entrenamiento más sistemático y menos traumático para estudiantes. Donde antes un aprendiz podía observar solo un número limitado de operaciones rápidas antes de verse obligado a intentarlas, ahora podía presenciar múltiples intervenciones detalladas y recibir instrucción paso a paso durante procedimientos prolongados. La pedagogía quirúrgica transitó desde el modelo de «observar unos pocos, realizar uno, enseñar uno» hacia un paradigma de entrenamiento gradual y supervisado.

Quizás el cambio más profundo concierne la relación de la sociedad con el dolor. La demostración de que el dolor quirúrgico—considerado durante milenios inevitable—podía eliminarse, inspiró una reconceptualización cultural del sufrimiento físico. Si este dolor «necesario» podía evitarse, ¿qué otros dolores considerados inevitables podrían también aliviarse? Esta pregunta inspiró desde el desarrollo de analgésicos modernos hasta transformaciones en el parto, cuidados paliativos y manejo del dolor crónico.

La humanización del quirófano representa así una transformación no solo técnica sino profundamente cultural, que reconfigura relaciones entre profesionales sanitarios, pacientes, y sociedad. Esta dimensión humana del impacto de la anestesia, aunque menos visible en los libros de historia médica que los avances quirúrgicos espectaculares que posibilitó, constituye quizás su legado más significativo y perdurable.